Kû¥ltû¥r Sanat

Deepfake videolaráÝnáÝn sayáÝsáÝ her yáÝl %900 oranáÝnda artáÝyor!

Dû¥nya Ekonomik Forumu’na (WEF) gûÑre ûÏevrimiûÏi deepfake videolaráÝn sayáÝsáÝ her yáÝl %900 oranáÝnda artáÝyor.

Dû¥nya Ekonomik Forumu’na (WEF) gûÑre ûÏevrimiûÏi deepfake videolaráÝn sayáÝsáÝ her yáÝl %900 oranáÝnda artáÝyor. Taciz, intikam ve kripto dolandáÝráÝcáÝláÝááÝ ile ilgili raporlarla birlikte birûÏok ûÑnemli deepfake dolandáÝráÝcáÝláÝk vakasáÝ haber manéetlerine ûÏáÝktáÝ. Kaspersky araétáÝrmacáÝlaráÝ, kullanáÝcáÝlaráÝn dikkat etmesi gereken ve deepfake kullanan ilk û¥ûÏ dolandáÝráÝcáÝláÝk planáÝna áÝéáÝk tutuyor.ô

Yapay sinir aálaráÝnáÝn, derin ûÑárenmenin ve dolayáÝsáÝyla deepfake aldatma tekniklerinin kullanáÝmáÝ, dû¥nyanáÝn dûÑrt bir yanáÝndaki kullanáÝcáÝlaráÝn yû¥zlerini veya vû¥cutlaráÝnáÝ dijital olarak deáiétirmeye, bûÑylece herhangi birinin baéka biri gibi gûÑrû¥ndû¥áû¥ gerûÏekûÏi gûÑrû¥ntû¥, video ve ses materyallerini û¥retmeye olanak saáláÝyor. Bu manipû¥le edilmié video ve gûÑrû¥ntû¥ler sáÝkláÝkla yanláÝé bilgi yaymak ve diáer kûÑtû¥ niyetli amaûÏlarla kullanáÝláÝyor.

Finansal dolandáÝráÝcáÝláÝk

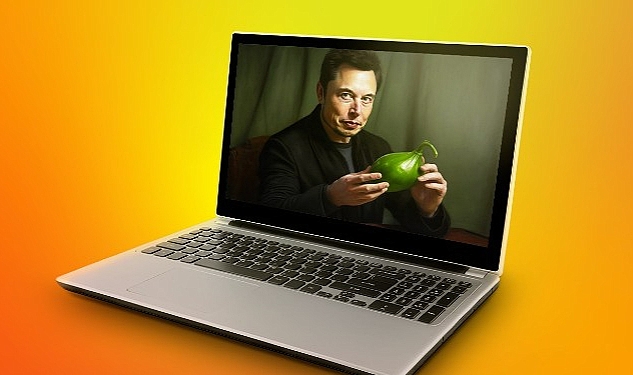

Deepfake’ler, suûÏlularáÝn kurbanlaráÝ tuzaáa ûÏekmek amacáÝyla û¥nlû¥leri taklit etmek iûÏin geliétirdikleri gûÑrû¥ntû¥lerin kullanáÝldáÝááÝ sosyal mû¥hendislik tekniklerine konu olabiliyor. ûrneáin Elon Musk’áÝn éû¥pheli bir kripto para yatáÝráÝm planáÝndan yû¥ksek getiri vaat eden yapay olarak oluéturulmué birô videosu, geûÏen yáÝl háÝzla yayáÝlarak kullanáÝcáÝlaráÝn para kaybetmelerine neden oldu. DolandáÝráÝcáÝlar bunun gibi sahte videolar yaratmak iûÏin û¥nlû¥lerin gûÑrû¥ntû¥lerini kullanáÝyor, eski videolaráÝ bir araya getiriyor ve sosyal medya platformlaráÝnda canláÝ yayáÝnlar baélatarak kendilerine gûÑnderilen herhangi bir kripto para ûÑdemesini iki katáÝna ûÏáÝkarma sûÑzû¥ veriyor.

Pornografik deepfake

Deepfake’lerin bir baéka kullanáÝm alanáÝ da bireyin mahremiyetini ihlal etmek. Deepfake videolar, bir kiéinin yû¥zû¥nû¥n pornografik bir video û¥zerine yerleétirilmesiyle oluéturulabiliyor ve bû¥yû¥k zarara ve sáÝkáÝntáÝya neden olabiliyor. Bir vakada, bazáÝ û¥nlû¥lerin yû¥zlerinin mû¥stehcen sahnelerdeki pornografik aktrislerin vû¥cutlaráÝna bindirildiái deepfake videolaráÝnáÝn internette yayáÝldáÝááÝ ortaya ûÏáÝktáÝ. SonuûÏ olarak, bu tû¥r vakalarda saldáÝráÝ maádurlaráÝnáÝn itibarlaráÝ zedeleniyor ve haklaráÝ ihlal ediliyor.

á¯ée dair riskler

ûoáu zaman deepfake’ler éirket yûÑneticilerinden haraûÏ alma, éantaj ve endû¥striyel casusluk gibi suûÏlar iûÏin iéletmeleri hedef almak û¥zere kullanáÝláÝyor. ûrneáin, siber suûÏlular bir ses deepfake’i kullanarak BAE’deki bir banka mû¥dû¥rû¥nû¥ kandáÝrmayáÝ ve 35 milyon dolar ûÏalmayáÝô baéarmáÝétáÝ. SûÑz konusu vakada ikna edici bir deepfake oluéturmak iûÏin patronunun sesinin sadece kû¥ûÏû¥k bir kaydáÝnáÝn ele geûÏirilmesi yeterliydi. Bir baékaô vakada, dolandáÝráÝcáÝlar en bû¥yû¥k kripto para platformu Binance’i kandáÝrmaya ûÏaláÝétáÝ. Binance yûÑneticisi, hiûÏ katáÝlmadáÝááÝ bir Zoom toplantáÝsáÝ hakkáÝnda “Teéekkû¥r ederim!” mesajlaráÝ almaya baéladáÝááÝnda éaéáÝrdáÝ. SaldáÝrganlar, yûÑneticinin herkese aûÏáÝk gûÑrû¥ntû¥leriyle bir deepfake oluéturmayáÝ ve bunu ûÏevrimiûÏi bir toplantáÝda yûÑnetici adáÝna konuéarak uygulamayáÝ baéardáÝlar.

FBI, insan kaynaklaráÝ yûÑneticilerini uyaráÝyor!

Genel olarak, deepfake’leri kullanan dolandáÝráÝcáÝlaráÝn amaûÏlaráÝ arasáÝnda dezenformasyon ve kamuoyunu manipû¥le etme, éantaj ve casusluk yer aláÝyor. Birô FBI uyaráÝsáÝnaô gûÑre, insan kaynaklaráÝ yûÑneticileri uzaktan ûÏaláÝémak iûÏin baévuran adaylar tarafáÝndan deepfake kullanáÝmáÝ konusunda zaten tetikte bekliyor. Binance vakasáÝnda, saldáÝrganlar deepfake oluéturmak iûÏin internetten gerûÏek kiéilerin gûÑrû¥ntû¥leri kullandáÝlar ve hatta bu kiéilerin fotoáraflaráÝnáÝ ûÑzgeûÏmiélere eklediler. á¯nsan kaynaklaráÝ yûÑneticilerini bu éekilde kandáÝrmayáÝ baéaráÝrlarsa ve sonrasáÝnda bir teklif aláÝrlarsa, devamáÝnda iéveren verilerini ûÏalabiliyorlar.

Deepfake’ler bû¥yû¥k bir bû¥tûÏe gerektiren ve sayáÝlaráÝ giderek artan pahaláÝ bir dolandáÝráÝcáÝláÝk tû¥rû¥ olmaya devam ediyor. Kaspersky tarafáÝndan daha ûÑnce yapáÝlan birô araétáÝrma, darknet û¥zerindeki deepfake’lerin maliyetini ortaya koyuyor. SáÝradan bir kullanáÝcáÝ internette bir yazáÝláÝm bulur ve bir deepfake yapmaya ûÏaláÝéáÝrsa, sonuûÏ gerûÏekûÏi olmayacak ve sahtekarláÝk bariz oluyor. ûok az insan dû¥éû¥k kaliteli bir deepfake’e inanáÝyor. Yû¥z ifadesindeki gecikmeleri veya ûÏene éeklindeki bulanáÝkláÝááÝ hemen fark edebiliyor.

Bu nedenle, siber suûÏlular bir saldáÝráÝya hazáÝrlanáÝrken bû¥yû¥k miktarda veriye ihtiyaûÏ duyuyor. Taklit etmek istedikleri kiéinin fotoáraflaráÝ, videolaráÝ ve sesleri gibi. FarkláÝ aûÏáÝlar, áÝéáÝk parlakláÝááÝ, yû¥z ifadeleri, hepsi nihai kalitede bû¥yû¥k rol oynuyor. Sonucun gerûÏekûÏi olmasáÝ iûÏin gû¥ncel bir bilgisayaráÝn gû¥cû¥ ve yazáÝláÝmáÝ gerekiyor. Tû¥m bunlar bû¥yû¥k miktarda kaynak gerektiriyor ve bu kaynaáa yalnáÝzca az sayáÝda siber suûÏlu eriéebiliyor. Bu nedenle deepfake saálayabileceái tehlikelere raámen hala son derece nadir bir tehdit olmaya devam ediyor ve yalnáÝzca az sayáÝda aláÝcáÝ bunu karéáÝlayabiliyor. Netice olarak bir dakikaláÝk bir “deepfake’in fiyatáÝ 20 bin ABD dolaráÝndan baéláÝyor.

ãBazen itibar riskleri ûÏok ciddi sonuûÏlar doáurabilirã

Kaspersky’de KáÝdemli Gû¥venlik UzmanáÝô Dmitry Anikin, éunlaráÝ sûÑylû¥yor:ô “Deepfake’in iéletmeler iûÏin oluéturduáu en ciddi tehditlerden biri her zaman kurumsal verilerin ûÏaláÝnmasáÝ deáildir. Bazen itibar riskleri ûÏok ciddi sonuûÏlar doáurabilir. YûÑneticinizin (gûÑrû¥nû¥ée gûÑre) hassas konularda kutuplaétáÝráÝcáÝ aûÏáÝklamalar yaptáÝááÝ bir videonun yayáÝnlandáÝááÝnáÝ dû¥éû¥nû¥n. éirket iûÏin bu durum hisse fiyatlaráÝnda háÝzláÝ bir dû¥éû¥ée yol aûÏabilir. Ancak, bûÑyle bir tehdidin riskleri son derece yû¥ksek olmasáÝna raámen, deepfake oluéturmanáÝn maliyeti ve ûÏok az saldáÝrganáÝn yû¥ksek kaliteli bir deepfake oluéturabilmesi nedeniyle bu éekilde saldáÝráÝya uárama éansáÝnáÝz son derece dû¥éû¥ktû¥r.ô Bu konuda yapabileceáiniz éey, deepfake videolaráÝn temel ûÑzelliklerinin farkáÝnda olmak ve size gelen sesli mesaj ve videolara éû¥pheyle yaklaémaktáÝr. AyráÝca, ûÏaláÝéanlaráÝnáÝzáÝn deepfake’in ne olduáunu ve nasáÝl fark edebileceklerini anladáÝklaráÝndan emin olun. ûrneáin sarsáÝntáÝláÝ hareket, cilt tonunda kaymalar, garip gûÑz káÝrpma veya hiûÏ gûÑz káÝrpmama gibi iéaretler belirleyici olacaktáÝr.”

Darknet kaynaklaráÝnáÝn sû¥rekli olarak izlenmesi, deepfake endû¥strisi hakkáÝnda deáerli bilgiler saálayarak araétáÝrmacáÝlaráÝn bu alandaki tehdit aktûÑrlerinin en son eáilimlerini ve faaliyetlerini takip etmelerine olanak saáláÝyor. AraétáÝrmacáÝlar darknet’i izleyerek deepfake’lerin oluéturulmasáÝ ve daááÝtáÝmáÝ iûÏin kullanáÝlan yeni araûÏlaráÝ, hizmetleri ve pazar yerlerini ortaya ûÏáÝkarabiliyor. Bu tû¥r bir izleme, deepfake araétáÝrmasáÝnáÝn kritik bir bileéenini oluéturuyor ve geliéen tehdit ortamáÝna iliékin anlayáÝéáÝmáÝzáÝ geliétirmemize yardáÝmcáÝ oluyor.ô Kaspersky Dijital Ayak á¯zi á¯stihbaratáÝô hizmeti, mû¥éterilerinin deepfake ile ilgili tehditler sûÑz konusu olduáunda bir adáÝm ûÑnde olmalaráÝna yardáÝmcáÝ olmak iûÏin bu tû¥r bir izleme iûÏeriyor.

Kaspersky Daily’de deepfake endû¥strisi hakkáÝnda daha fazla bilgi edinebilirsiniz.

Kaspersky, deepfake’lerle ilgili tehditlerden korunmak iûÏin éunlaráÝ ûÑneriyor:

- Kuruluéunuzdaki siber gû¥venlik uygulamalaráÝnáÝ kontrol edin- yalnáÝzca yazáÝláÝm aûÏáÝsáÝndan deáil, geliémié BT becerileri aûÏáÝsáÝndan da. Mevcut tehdit ortamáÝnáÝn ûÑnû¥ne geûÏmek iûÏinô Kaspersky Threat Intelligenceô kullanáÝn.ô

- Kurumsal “insan gû¥venlik duvaráÝnáÝ” gû¥ûÏlendirin. ûaláÝéanlaráÝnáÝzáÝn deepfake’in ne olduáunu, nasáÝl ûÏaláÝétáÝklaráÝnáÝ ve oluéturabilecekleri zorluklaráÝ anladáÝááÝndan emin olun. ûaláÝéanlara bir deepfake’i nasáÝl tespit edeceklerini ûÑáretmek iûÏin sû¥rekli farkáÝndaláÝk ve eáitim ûÏaláÝémalaráÝ yapáÝn.ô Kaspersky Automated Security Awareness Platform, ûÏaláÝéanlaráÝn en yeni tehditler konusunda gû¥ncel kalmasáÝna yardáÝmcáÝ olur ve dijital okuryazarláÝk seviyelerini artáÝráÝr.

- Kaliteli haber kaynaklaráÝna baévurun. Cehalet ve bilgi eksikliái deepfake’lerin yaygáÝnlaémasáÝnda ûÑnemli bir etken olmaya devam etmektedir.ô

- ‘Gû¥ven ama doárula’ gibi saálam protokolleri devreye aláÝn. Sesli mesaj ve videolara éû¥pheyle yaklaémak insanlaráÝn asla kandáÝráÝlmayacaááÝnáÝ garanti etmez, ancak yaygáÝn tuzaklaráÝn ûÏoáundan kaûÏáÝnmaya yardáÝmcáÝ olabilir.ô

- Deepfake kurbanáÝ olmamak iûÏin videolaráÝn dikkat edilmesi gereken temel ûÑzelliklerinin farkáÝnda olun. SarsáÝntáÝláÝ hareket, bir kareden diáerine áÝéáÝkta kaymalar, cilt tonunda deáiéimler, garip gûÑz káÝrpmalar veya hiûÏ gûÑz káÝrpmama, konuémayla uyum saálamayan dudaklar, gûÑrû¥ntû¥deki dijital yapayláÝklar, kasáÝtláÝ olarak dû¥éû¥k kalitede kodlanmáÝé ve zayáÝf aydáÝnlatmaya sahip videolar gibi.

ô

Kaynak: (BYZHA) Beyaz Haber AjansáÝ